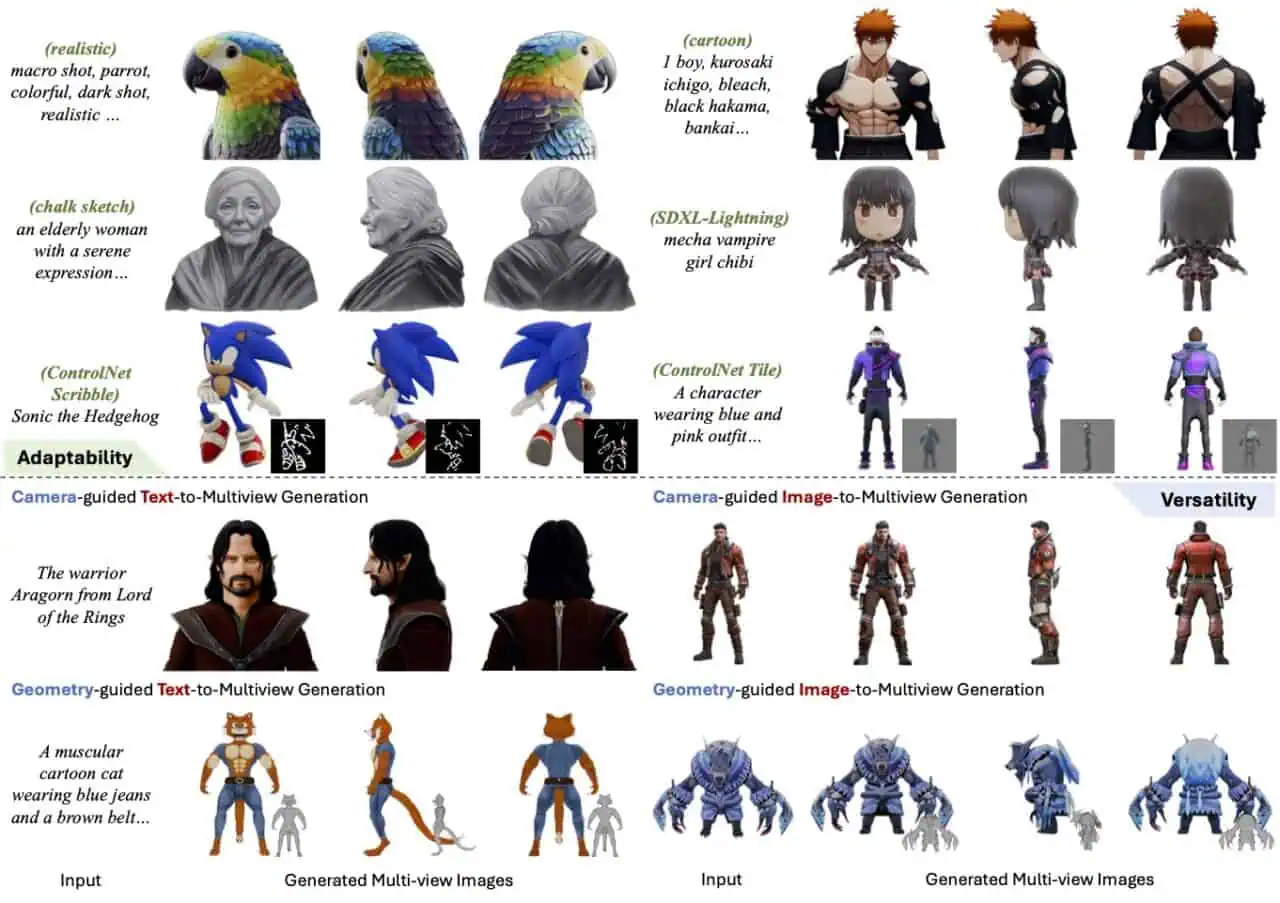

北京大学ソフトウェア学院、VAST(Tripoの会社)、上海交通大学の研究者らによる「MV-Adapter: Multi-view Consistent Image Generation Made Easy」が公開されています。テキストや画像から制度の高いマルチアングル画像を生成しテクスチャとして適用出来る技術です!

MV-Adapter: Multi-view Consistent Image Generation Made Easy

既存のマルチビュー画像生成手法では、学習済みのテキスト画像(T2I)モデルに侵襲的な変更を加えることが多く、完全な微調整が必要であるため、(1)特に大規模なベースモデルや高解像度画像では計算コストが高い、(2)最適化が困難で高品質な3Dデータが少ないため画質が劣化する、といった問題がある。 本論文では、マルチビュー画像生成のためのアダプタベースのソリューションを初めて提案し、元のネットワーク構造や特徴空間を変更することなく、T2Iモデルやその派生モデルを拡張する汎用性の高いプラグアンドプレイアダプタであるMV-Adapterを紹介する。 MV-Adapterは、より少ないパラメータを更新することで、効率的な学習を可能にし、事前学習済みモデルに埋め込まれた事前知識を保持することで、オーバーフィッティングのリスクを軽減する。アダプタ内で3D幾何学的知識を効率的にモデル化するために、我々は、重複した自己注意層と並列注意アーキテクチャを含む革新的な設計を導入し、アダプタが新しい3D知識をモデル化するために、事前に訓練されたモデルの強力な事前分布を継承することを可能にする。 さらに、カメラパラメータと幾何学的情報をシームレスに統合する統合条件エンコーダを提示し、テキストベースや画像ベースの3D生成やテクスチャリングなどのアプリケーションを容易にする。 MV-Adapterは、Stable Diffusion XL (SDXL)上で768解像度のマルチビュー生成を実現し、適応性と汎用性を示している。 また、任意のビュー生成への拡張も可能であり、より幅広い応用が可能です。 MV-Adapterがマルチビュー画像生成の新たな品質基準を設定し、その効率性、適応性、汎用性により新たな可能性を開くことを実証する。

いやぁすごい・・マルチアングル画像があるだけでかなり精度が上がりますよね。

Hugging Faceのページでは、テキストから3Dモデルにテクスチャを適用したり、画像から3Dモデルにテクスチャ適用するデモを実際に試すことができます。

詳細はプロジェクトページやGithubなどをチェックしてみてください!

リンク

ちなみにComfyUI版もありますね

コメント