Xingang Pan氏、Ayush Tewari氏、Thomas Leimkühler氏、Lingjie Liu氏、Abhimitra Meka氏、Christian Theobalt氏らよる「Drag Your GAN: Interactive Point-based Manipulation on the Generative Image Manifold」が話題になっています。

※2023/05/20 – 動画を追加

※2023/05/25 – コードやデモページへのリンクを追加

Drag Your GAN: Interactive Point-based Manipulation on the Generative Image Manifold

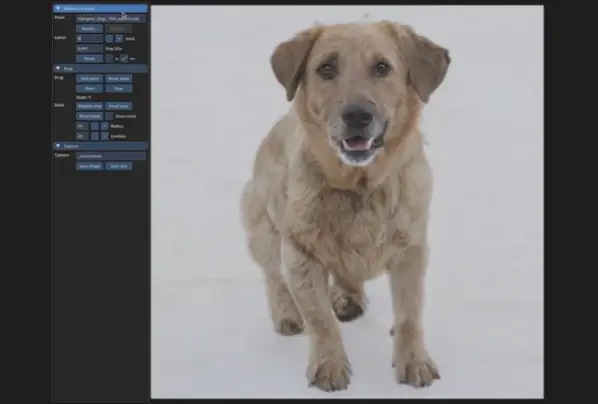

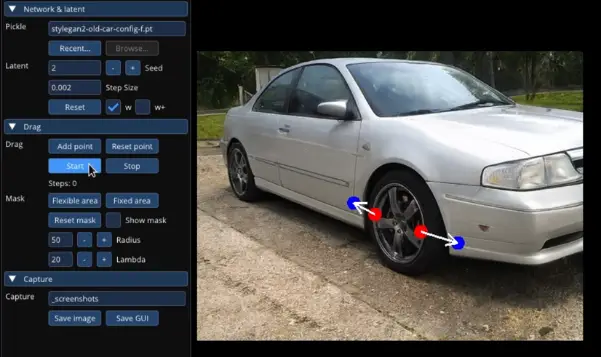

ユーザーのニーズに合ったビジュアルコンテンツを合成するためには、生成されるオブジェクトのポーズ、形状、表情、レイアウトを柔軟かつ正確に制御できることが必要です。既存のアプローチでは、手動でアノテーションされた学習データや事前の3Dモデルによって生成的敵対ネットワーク(GAN)の制御性を得ているが、柔軟性、精度、汎用性に欠けることが多い。本研究では、GANを制御する強力な方法として、図1に示すように、画像の任意の点を「ドラッグ」して、ユーザーと対話しながら目標点に正確に到達させるという、まだあまり知られていない方法を研究します。これを実現するために、我々は2つの主要コンポーネントからなるDragGANを提案します: 1)ハンドルポイントを目標位置に移動させる特徴ベースの動作監視、2)ハンドルポイントの位置を定位し続けるために識別可能なジェネレータの特徴を活用する新しいポイントトラッキングのアプローチ、です。DragGANは、ピクセルの位置を正確に制御しながら画像を変形させることができるため、動物、車、人間、風景など様々なカテゴリーのポーズ、形状、表情、レイアウトを操作することができます。これらの操作は、学習されたGANの生成画像多様体上で行われるため、オクルージョンの幻覚や、物体の剛性に一貫して従う形状の変形など、困難なシナリオでもリアルな出力が得られる傾向にあります。定性的・定量的な比較の両方から、画像操作と点追跡のタスクにおいて、先行アプローチに対するDragGANの優位性が実証されています。また、GAN反転による実画像の操作についても紹介する。

写真加工の難易度がぐぐっと下がる素敵な技術。

車の加工も自由自在!

いやぁ凄いですね…早く触ってみたいなぁ。現時点ではコードは公開されておりません。SIGGRAPH2023に合わせて公開されるのかな?その他詳細はプロジェクトページをご確認ください!

コメント