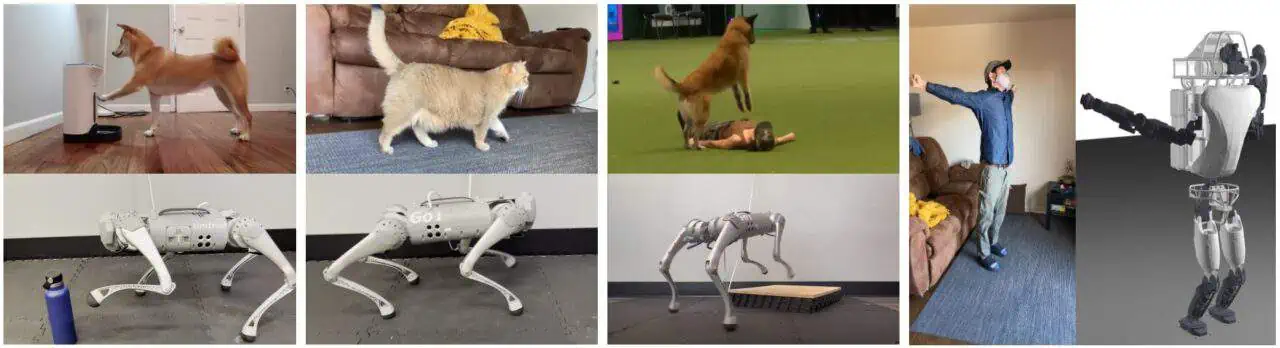

何気なく取った動物や人物の映像から脚式ロボット向けに動きを転送する為のフレームワーク『SLoMo: A General System for Legged Robot Motion Imitation from Casual Videos』が公開されています。

SLoMo: A General System for Legged Robot Motion Imitation from Casual Videos

SLoMoは、人間や動物が何気なく撮影したビデオ映像から、熟練した動作を脚式ロボットに転送するための、世界で初めてのフレームワークである。SLoMoは3つの段階で動作する: 1)単眼映像から物理的に妥当な再構成されたキーポイント軌道を合成する。2)キーポイントを忠実に追跡する接触シーケンスだけでなく、体や足の動きを含む、ロボットのための動的に実現可能な参照軌道をオフラインで最適化する。3)ロボットのハードウェア上で汎用モデル予測コントローラを用いて参照軌道をオンラインで追跡する。脚の運動スキルのための従来の動作模倣は、多くの場合、専門のアニメーター、共同デモンストレーション、および/または高価なモーションキャプチャ機器を必要とし、これらすべてがスケーラビリティを制限する。代わりに、SLoMoは、YouTubeのようなオンラインリポジトリで簡単に入手できる単眼ビデオ映像のみに依存します。SLoMoは、ビデオを実世界のロボットが確実に実行できるモーション・プリミティブに変換する。我々は、猫、犬、人間の動きを、四足歩行ロボット(ハードウェア)とヒューマノイド(シミュレーション)を含むサンプルロボットに転送することで、我々のアプローチを実証する。筆者らの知る限り、これは、人工的なマーカーやラベルを使わずに、何気ないビデオから直接、脚式ロボットに動物や人間のモーションを模倣する、汎用的なモーショントランスファーフレームワークの最初の試みである。

この手のモーション転送技術はロボット業界へも色々影響を与えそうで楽しみですね。

Github上でコードも公開されています。気になる方はチェックしてみてね。

コメント