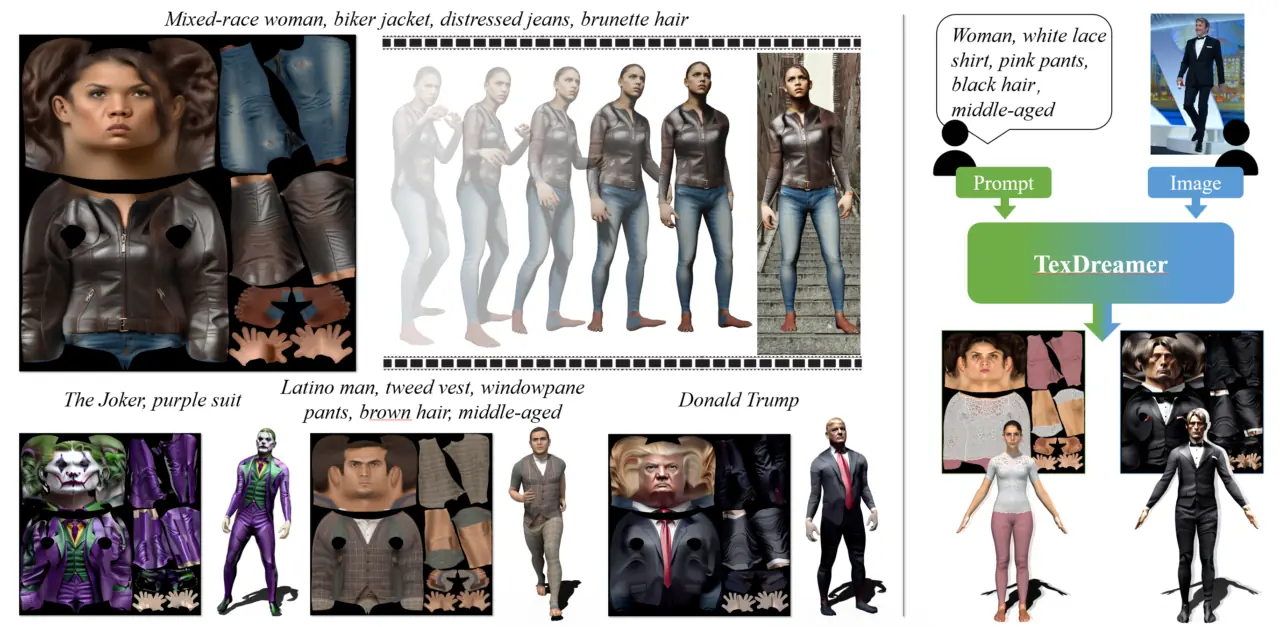

テキストや入力画像から3D人体のテクスチャを生成出来るモデル『TexDreamer: Towards Zero-Shot High-Fidelity 3D Human Texture Generation』の技術ページが公開されています!

TexDreamer: Towards Zero-Shot High-Fidelity 3D Human Texture Generation

TexDreamerは、テキストと画像の両方の入力をサポートする、初のゼロショット高忠実度3D人体テクスチャ生成モデルです。

効率的なテクスチャ適応の微調整により、TexDreamerはテキストからセマンティックな3DヒューマンUVテクスチャを生成するための忠実なアイデンティティと服装を示します。セマンティックUVマップを用いた3D人間のテクスチャリングは、合理的に展開されたUVを取得することが困難であるため、依然として課題となっている。最近、大規模なT2I(text-to-image)モデルを用いたマルチビューレンダリングのスーパーバイジングにおけるtext-to-3Dの進歩にもかかわらず、生成速度、テキストの一貫性、およびテクスチャの品質に問題が残っており、その結果、既存のデータセットにはデータが不足している。我々は、初のゼロショットマルチモーダル高忠実度3D人間テクスチャ生成モデルであるTexDreamerを発表する。効率的なテクスチャ適応微調整戦略を利用し、元の汎化能力を維持しながら、大規模なT2IモデルをセマンティックUV構造に適応させる。新しい特徴変換モジュールを活用することで、学習されたモデルは、テキストまたは画像のどちらからでも、数秒以内に忠実度の高い3D人体テクスチャを生成することができる。さらに、ArTicuLated humAn textureS (ATLAS)を紹介する。ATLASは最大の高解像度(1024×1024)3D人体テクスチャデータセットであり、50kの高忠実度テクスチャとテキスト説明を含む。このデータセットとモデルは、研究目的で公開される予定である。

ほほう…これは今後の進化に期待ですね。

詳細は公式のプロジェクトページをご確認ください。GithubページはまだComingSoonですね。

コメント